Azi, trăim într-un ev al progresului tehnologic accelerat, în care realitatea se apropie ameţitor de rapid de viziunea lui Asimov. Roboţii fac tot mai mult parte din viaţa noastră, tot mai inteligenţi, tot mai autonomi, mai capabili să iniţieze singuri acţiuni, să „gândească cu capul lor” – chiar dacă acel „cap” e un procesor -, să treacă dincolo de condiţionările impuse de controlul uman. În aceste condiţii, un robot poate face mult bine şi la fel de mult rău. Iată-ne ajunşi deja în situaţia de a elabora un cod moral pentru roboţii noştri, un sistem de legi asemenei celui gândit de Asimov. Viziunea lui a devenit realitate, viitorul este deja aici. Dar oare aceste cod moral este atât de uşor de elaborat?

Legile roboţilor şi intepretările lor

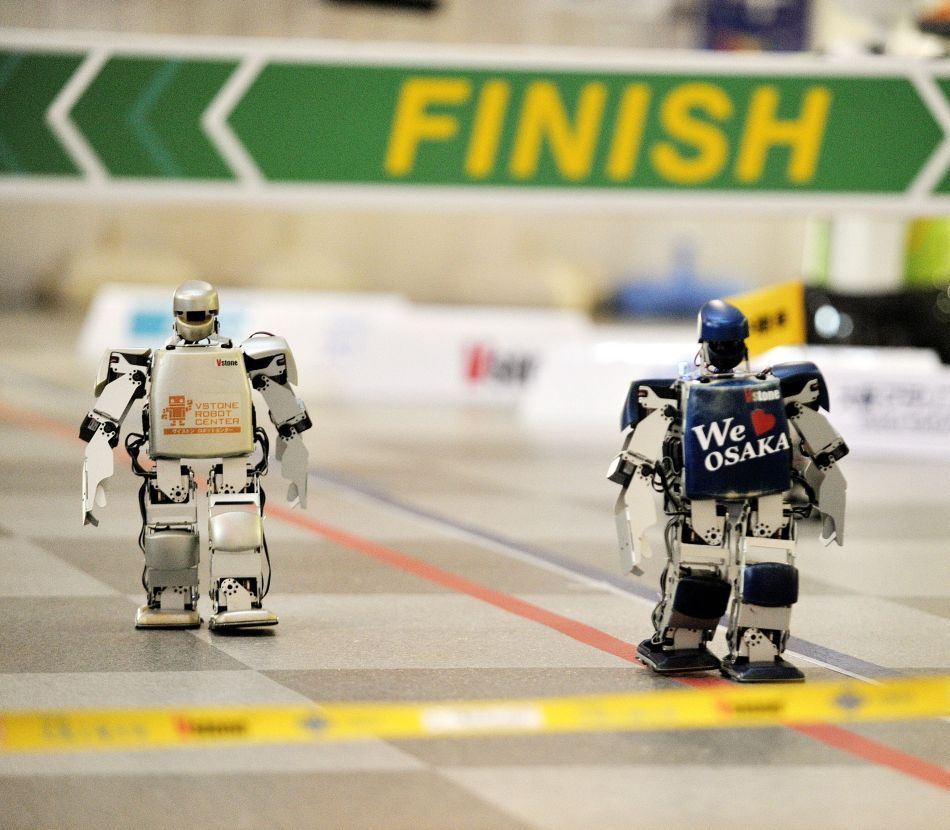

Mii de proiecte se concentrează, la ora actuală, asupra construirii unor maşinării care să fie nu doar capabile să se deplaseze, să comunice, să îndeplinească sarcini precis trasate de oameni, ci şi să ia decizii, în funcţie de condiţii, să aleagă singure soluţii; cu alte cuvinte, să fie autonome. Iar prin maşinării sau roboţi, înţelegem nu doar nişte roboţi umanoizi (care, oricum, reprezintă o minoritate în lumea roboţilor de azi), ci şi numeroşii roboţi militari şi utilitari de toate formele şi mărimile, precum şi sistemele computerizate care asigură activitatea autonomă a celor mai variate alcătuiri şi care vor juca în viitor un rol imens, fiind integrate în mii de sisteme, de la drone la utilaje folosite în construcţii, de la aparate electrocasnice la vehicule submarine, de la maşinile fără şofer la mini-roboţii chirurgicali. Cu alte cuvinte – orice sistem care „gândeşte” cu ajutorul unor procesoare, fiind înzestrat cu aşa-numita inteligenţă artificială.

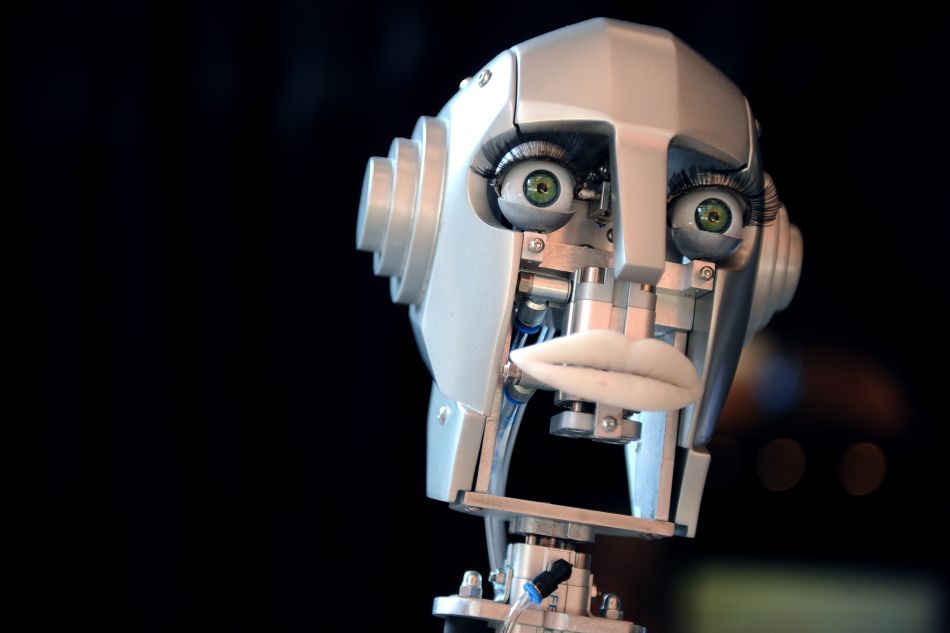

Scopul suprem al cercetărilor în domeniul inteligenţei artificiale este acela de a crea maşinării care să fie cât mai apropiate de om, în ceea ce priveşte capacităţile cognitive şi de decizie. Savanţii visează la sisteme automate care, la fel ca omul, să evalueze rapid situaţia, să-şi recheme în amintire cunoştinţele acumulate anterior, să treacă totul prin sita regulilor morale şi, integrând toate aceste aspecte, să ia o decizie pe baza căreia să acţioneze. Pare simplu. Dar nu este.

Roboţii lui Asimov aveau de respectat trei legi, mari şi late, toate însă având la bază interdicţia de a face rău unei fiinţe umane.

Un articol publicat recent în The Economist atrăgea însă atenţia asupra unor scenarii – ipotetice, deocamdată – în care un „robot” ascultător şi bine educat, pătruns de importanţa celor trei legi şi hotărât să le respecte, ar fi fost pus în situaţii extrem de dificile. Ce ar trebui să facă, de pildă, o maşină fără şofer, când apare pericolul de a lovi nişte pietoni:: să vireze brusc pentru a-i evita, cu riscul de a-şi vătăma ocupanţi şi de a lovi alte maşini? Sau o dronă care trebuie să tragă asupra unui imobil unde se ascunde un terorist, ce-ar trebui să facă? Să distrugă imobilul cu orice preţ, pentru a-şi îndeplini obiectivul, chiar dacă asta înseamnă să omoare şi civili nevinovaţi care se găsesc în acelaşi imobil?

De altfel, însuşi Asimov, în câteva dintre nuvelele scrise de-a lungul vieţii, după publicarea Runaround, a imaginat scenarii în care roboţii încălcau una sau alta dintre legi sau cel puţin visau să o facă. , sugerând astfel că niciun set de reguli fixe nu poate acoperi deplin toate situaţiile posibile. Ceea ce dovedeşte că lucrurile nu sunt niciodată atât de simple ca pe hârtie.

O chestiune actuală

În ciuda faptului că Legile Roboţilor au fost formulate în urmă cu 7 decenii, problema unui cod moral a început să se pună cu acuitate abia în ultimii ani, când o dezvoltare vijelioasă a sistemelor dotate cu inteligenţă artificială i-a silit pe oameni să conştientizeze faptul că, odată cu reuşitele, iese la iveală şi o latură îngrijorătoare: cea a modului în care se vor purta aceste creaţii – aproape creaturi – atunci când vor deveni autonome, aşa cum îşi doresc creatorii lor. Aşadar, vorbim despre un fenomen foarte recent. Ca dovadă, lucrările cuprinzătoare asupra acestui subiect sunt de dată recentă:

Şi tot aşa, marea majoritate a cărţilor şi articolelor de specialitate, precum şi a articolelor de popularizare apărute în diverse publicaţii datează abia de câţiva ani, ceea ce pare să indice faptul că problema a devenit acută. Fără îndoială, fenomenul se leagă de faptul că, în ultimii câţiva ani, roboţii şi, în general, sistemele dotate cu inteligenţă artificială au devenit, într-adevăr, capabile de multe, de diferite acţiuni şi decizii, ceea ce pune cu stringenţă problema unei educaţii morale a acestor alcătuiri.

Sub ochii noştri, ia naştere un tip nou de creatură: se vorbeşte deja despre o categorie aparte de „fiinţe”, aşa-numiţii agenţi morali artificiali (AMA), sisteme dotate cu inteligenţă artficială, dar care vor putea (şi vor trebui) să ia decizii nu doar în funcţie de condiţiile obiective, ci şi în conformitate cu o morală care le va fi „băgată în cap” de cei care i-au proiectat şi construit.

Experimente, opinii, viziuni

Iată câteva dintre studiile recente ce ilustrează importanţa enormă a acestui aspect al tehnologiei, precum şi părerile unor specialişti în privinţa acestei complicate chestiuni:

În 2008, un expert în inteligenţă artificială, Noel Sharkey, de la Universitatea din Sheffield, Marea Britanie, atrăgea atenţia asupra acestui aspect, afirmând că roboţii construiţi pentru a-i amuza pe copii şi a-i îngriji pe bătrâni ar trebui supuşi unor rigori etice.

Însă nu numai roboticienii şi specialiştii în etica tehnolgiei, ci înşişi experţii militari atrag atenţia asupra necesităţii de a-i înzestra pe roboţi cu un asemenea cod, de a-i învăţa, altfel spus, să deosebească binele de rău, cel puţin aşa cum sunt ele definite în sistemul de valori al societăţii moderne de tip ocidental şi aşa cum sunt înţelese ele pe timp de război. (Iată încă un aspect care complică problema: alte grupuri umane, cu alte coduri morale şi alte sisteme de valori, ar putea construi roboţi care să se comporte după alte reguli decât roboţii „noştri”, iar rezultatul, cel puţin pentru moment, e aproape imposibil de prevăzut.) Cu perspectiva transformării războiului într-unul purtat, în mare măsură, cu ajutorul unor sisteme dotate cu inteligenţă artificială, comportamentul unui robot pe front ar trebui să fie supus unui cod la fel de strict ca şi cel care guvernează azi comportamentul soldaţilor umani. Pentru că e clar că, dintre toţi roboţii, cei militari sunt cei cărora li se poate cere cel mai puţin să respecte legile formulate de Asimov. În acelaşi timp, aşa cum se menţionează în articolul din The Economist, un robot-soldat ar putea purta războiul făcând mult mai puţin rău decât unul uman: un soldat robot nu jefuieşte, nu violează, nu ucide şi distruge fără să se poată opri, cuprins de o furie care îl orbeşte…

Dar cât de probabilă este o evoluţie a roboţilor, care să facă necesară înzestrarea lor cu un cod moral? Un articol apărut în Popular Science aduce în scenă ciudatul personaj al robotului mincinos, nu un personaj de literatură fantastică, ci unul devenit real. E vorba despre un experiment realizat de cercetătorii Laboratorului de Sisteme Inteligente al Şcolii Politehnice Federale din Lausanne, Elveţia, experiment axat pe posibilităţile de evoluţie ale roboţilor, pe capacitatea lor de a învăţa şi de a coopera pentru a găsi o anumită resursă (un material util) şi a se feri de o sursă de material dăunător.

Experimentul a implicat 1000 de roboţi, împărţiţi în grupuri de câte zece. Fiecare robot era dotat cu un senzor, un sistem de semnalizare (o lumină albastră) şi un „genom” – un cod binar care controla modul în care roboţelul reacţiona la stimuli. Roboţii din prima generaţie au fost programaţi să îşi aprindă beculeţul albastru când descopereau sursa utilă, ajutându-i astfel şi pe ceilalţi roboţi să o găsească.

Aşadar, roboţii pot învăţa să mintă. Şi dacă se mint între ei, nu ne-ar putea minţi, într-o bună zi, şi pe noi? Şi, dacă ar ajunge să ne mintă, ce i-ar putea împiedica pe unii dintre ei să facă lucruri şi mai rele (din punctul nostru de vedere)? Unii dintre ei ne-ar putea vătăma fizic cu uşurinţă; înzestraţi cu arme (cine ştie dacă n-ar ajunge să le construiască singuri?) ne-ar putea chiar ucide. Sună a delir paranoic? Poate. Dar dacă marile utilaje industriale, lipsite de inteligenţă, reprezintă un pericol real pentru om atunci când sunt mânuite fără grija cuvenită, cu atât mai mult ar putea fi primejdios impactul cu un AMA lipsit de frânele morale care permit umanităţii să-şi ducă viaţa în relativă siguranţă.

Dacă preocupările academice serioase privind necesitatea de a înzestra AMA cu un cod de reguli morale sunt de dată recentă, obsesia confruntării cu un grup de AMA care evoluează în legea lor, fără a ţine seama de a noastră, i-a bântuit pe mulţi vizionari. O povestire SF scrisă de un autor sovietic, Anatoli Dneprov, publicată în anii ’50 şi intitulată Crabii mişună pe insulă, descria întocmai această viziune de coşmar: un savant construise nişte crabi robotici inteligenţi, programaţi „să se înmulţească” prin construirea altor crabi identici cu ei, din metalele puse la dispoziţie de el. Intenţia era aceea de a verifica dacă teoria darwinistă a evoluţiei se aplică şi sistemelor inteligente artificiale. În doar câteva zile, oamenii de ştiinţă care urmăreau experimentul au constatat că deja crabii evoluaseră, devenind mai mari şi mai bine înzestraţi. Când materialele din depozite s-au terminat, lucrurile au luat o turnură interesantă: crabii au început să se atace unii pe ceilalţi, învinşii fiind dezasamblaţi şi folosiţi drept materie primă de către învingători, pentru construirea altor crabi. În cele din urmă, n-a mai rămas decât un număr mic de crabi uriaşi, care se luptau tot timpul între ei. Şi, la un moment dat, s-a petrecut ceva la care nimeni nu se aşteptase: unul dintre crabi şi-a atacat creatorul, pe savantul Cookling. La început, lucrul a părut de neînţeles, până când oamenii şi-au dat seama că, de fapt, crabul nu făcea decât să-şi urmeze programul, să facă exact ceea ce fusese învăţat să facă: ascultând de programul său fundamental, care îi „spunea” să construiască întruna alţi crabi şi, în acest scop, să caute şi să procure neîncetat metal, crabul s-a năpustit asupra savantului, încercând să-i smulgă dinţii de metal, pentru a-i folosi la crearea altor monştri robotici.

Un scenariu extrem, desigur, dar iată că, la peste o jumătate de secol de la această interpretare, ne punem deja problema evoluţiei sistemelor inteligente artificiale, a limitelor acestei evoluţii, a modului în care le-am putea dota cu învăţămintele necesare unei convieţuiri armonioase cu omul, creatorul lor, atunci când graniţa dintre capacităţile cognitive umane şi cele ale AMA va deveni subţire de tot sau va dispărea.

Cum să-i învăţăm să distingă răul de bine? Cum să-i ferim de relele care ne bântuie pe noi şi care adesea scapă din strânsoarea frânelor morale, făcând atâta rău celor din jur: egoismul, lăcomia, setea de putere?

Deocamdată, îi controlăm noi pe ei, iar posibilitatea ca ei să preia controlul pare o utopie. Şi totuşi, faptul că oameni care lucrează zi de zi cu aceste sisteme (şi ştiu bine ce pot ele şi ce nu) sunt preocupaţi de chestiunea unei etici a funcţionării lor arată că vremea în care va trebui să găsim o bază morală pentru convieţuire nu e atât de departe cum credeam.